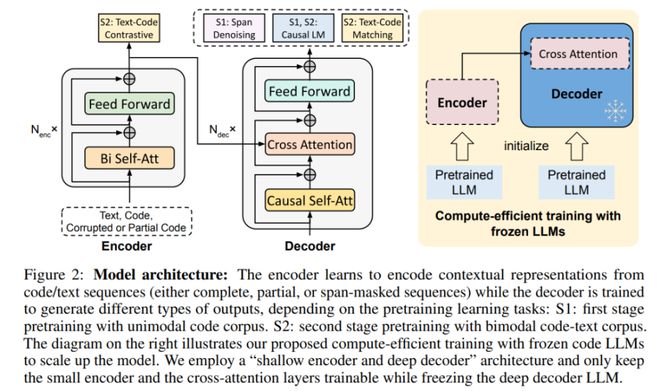

1、大模型架构之争Transformer的Encoder与Decoder之差异解析 Transformer架构的崛起,已经超越了CNNRNNLSTM和GRU的传统界限,引发了深度学习领域的广泛关注如今,LLM领域正围绕encoderonlyencoderdecoder与decoderonly三种设计展开激烈的讨论BERT曾引领encoderonly的热潮,然而,T5和GPT系列,特别是GPT;一切都得从 Transformer 说起Transformer 左半边为 Encoder,右半边为 Decoder我们将 Encoder 输入的句子称为 source,Decoder 输入的句子称为 target Encoder 负责将 source 进行 selfattention 并获得句子中每个词的 representation,最经典的 Encoder 架构就是 BERT,通过 Masked Language Model 来学习;每个Decoder由三部分组成Multihead selfattention层,EncoderDecoder Attention层和Feed Forward NN层动机当模型处理每个单词输入序列中的每个位置时,selfattention允许它查看输入序列中的其他位置以寻找可以帮助导致对该单词更好的编码的线索使用矩阵形式可以并行计算 图示 动机将信息。

2、Attention模型以机器翻译作为例子讲解最常见的Soft Attention模型的基本原理,之后抛离EncoderDecoder框架抽象出了注意力机制的本质思想,然后简单介绍最近广为使用的Self Attention的基本思路一般在自然语言处理应用里会把Attention模型看作是输出Target句子中某个单词和输入Source句子每个单词的对齐模型,这是;Transformer模型中采用了 encoerdecoder 架构,论文中encoder层由6个encoder堆叠在一起,decoder层也一样每一层的encoder和decoder的结构如下图所示transformer模型中缺少一种解释输入序列中单词顺序的方法,它跟序列模型还不不一样为了处理这个问题,transformer给encoder层和decoder层的输入添加了一个;Transformer的革新突破Google Brain团队的Transformer模型,摒弃了RNN和CNN,仅依赖注意力机制加上多层线性变换,其特点是高度并行,彻底改变了神经网络架构的游戏规则Transformer的结构与细节Transformer由Encoder和Decoder组成,Encoder引入selfAttention,使其能关注输入句子的每个部分尽管整体结构有序,但;只是我们介绍注意力机制的时候更多会用encoderdecoder框架做介绍 EncoderDecoder 框架可以看作是一种深度学习领域的研究模式,应用场景异常广泛下图是文本处理领域里EncoderDecoder 框架最抽象的一种表示 在NLP领域,可以把EncoderDecoder框架看作是将一个句子篇章转换成另一个句子篇章最直观的例子就是。

3、再比如在人机对话中,我们问机器“你是谁”,机器会返回答案“我是某某某”如下图所示为一个简单的邮件对话的场景,发送方问“你明天是否有空”接收方回答“有空,怎么了”#160 #160 #160 #160seq2seq属于encoderdecoder结构的一种,这里看看常见的encoderdecoder结构;seq2seq 是一个 Encoder–Decoder 结构 的网络,它的输入是一个序列,输出也是一个序列, Encoder 中将一个可变长度的信号序列变为固定长度的向量表达,Decoder 将这个固定长度的向量变成可变长度的目标的信号序列这个结构 最重要的地方 在于输入序列和输出序列的长度是可变的,可以用于翻译,聊天机器人。

4、Decoder是图1的右半部分,与左半部分的Encoder类似,但又存在一些区别Decoder比Encoder多了一个MultiHead Attention,第一个MultiHead Attention采用Masked操作,因为在生成任务中,前面的词语是看不到后面词语的信息的,因此需要加入Masked来避免信息泄露第二个MultiHead Attention输入的 是根据Encoder;本文结构seq2seq 是一个 Encoder–Decoder 结构 的网络,它的输入是一个序列,输出也是一个序列, Encoder 中将一个可变长度的信号序列变为固定长度的向量表达,Decoder 将这个固定长度的向量变成可变长度的目标的信号序列这个结构 最重要的地方 在于输入序列和输出序列的长度是可变的,可以用于翻译;Transformer 在机器翻译任务上的表现超过了 RNN,CNN,只用 encoderdecoder 和 attention 机制就能达到很好的效果,最大的优点是可以高效地并行化Transformer 是一种基于 encoderdecoder 结构的模型,在Encoder 中,在Decoder 中,下面我们具体看一下其中这几个概念,这里主要参考 Jay Alammar,他在 The Illustrated Transfo;探索未来交通流量的精准导航GMAN,交通预测的革命性模型AAAI 2020在智慧城市的大幕下,交通预测如同一道精密的导航灯,引领我们预见未来的道路拥堵GMAN,一个革命性的图多头注意力网络,凭借其强大的EncoderDecoder架构,正在AI领域熠熠生辉代码的开源宝典GitHub;很明显,这个问题直接可以由EncoderDecoder框架来进行下联自动生成这种场景是典型的EncoderDecoder框架应用问题我们所需要做的就是配置好EncoderDecoder框架的具体模型,比如Encoder和Decoder都采用RNN模型来做,图2展示了用EncoderDecoder框架做对联下联自动生成的架构图图2 EncoderDecoder生成下联只需要找到大量的对。

5、深度学习揭秘编码器解码器架构的奥秘在深度学习的广阔天地中,编码器解码器EncoderDecoder这一架构犹如一座桥梁,连接着输入与输出,引领着众多模型的发展脉络从CNN的别具一格,到RNN的灵活应用,编码器解码器的魔力无处不在编码器解码器的精髓作为模型设计的核心组件,编码器解码器由两;首先,让我们从模型的视角来区分encoder,就像一个魔术师,它将信息的宝藏转化为编码的密语,或者说是特征的提炼者它的任务是通过对输入数据进行复杂的处理,提取出关键特征,这些特征就如同数据的浓缩精华,为后续的分析和任务执行做好准备然后是decoder,它就像一个解码器,专门负责解读这些编码的;Attention 经常会和 EncoderDecoder 一起说,之前的文章 一文看懂 NLP 里的模型框架 EncoderDecoder 和 Seq2Seq 也提到了 Attention 下面的动图演示了attention 引入 EncoderDecoder 框架下,完成机器翻译任务的大致流程 但是,Attention 并不一定要在 EncoderDecoder 框架下使用的,他是可以脱离 EncoderDe。

还没有评论,来说两句吧...