温馨提示:这篇文章已超过376天没有更新,请注意相关的内容是否还可用!

1一种解释 token令牌tokenize令牌化tokenizer令牌解析器 2另一种翻译是token可以翻译为“标记”,tokenize可以翻译为“标记解析”或“解析标记”,tokenizer可以翻译为“标记解析器”在编写词法分析器Lexer或语;ltfieldType name=quottextquot class=quotsolrTextFieldquotltanalyzerlttokenizer class=quotsolrStandardTokenizerFactoryquotltanalyzerltfieldType元素的类名称不是一个真实的分词器,但是它指向一个实现了。

tokenizer和embedding区别

1、5 jieblcut 以及 jiebalcut_for_search 直接返回list 6 jiebaTokenizerdictionary=DEFUALT_DICT 新建自定义分词器,可用于同时使用不同字典,jiebadt为默认分词器,所有全局分词相关函数都是该分词器的映射。

2、import re str=quota = f1`MAXb, 00, 10 + 05quotprint resplit#39 +=+#39,str这样会多出一个#39#39,可以把最后一个字符串去掉print resplit#39 +=+#39,str1。

3、它只包括了 Lower Case 的 Tokenizer ,它会按照 非字母切分 , 非字母的会被去除 ,最后对切分好的做 转小写 处理,然后接着用刚才的输入文本,分词器换成 simple 来进行分词,运行结果如下从结果中可以看出。

4、加载格拉菲菲特模型 要加载格拉菲特模型,你可以使用以下代码```python importtorch fromtransformersimportGPT2Tokenizer,GPT2LMHeadModel tokenizer=GPT2Tokenizerfrom_pretrained#39gpt2#39model=GPT2。

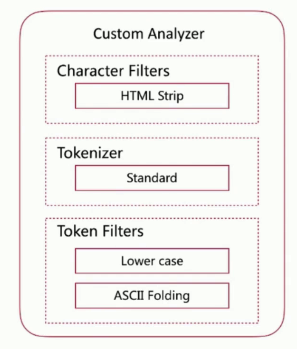

5、全文搜索引擎会用某种算法对要建索引的文档进行分析, 从文档中提取出若干 Token词元 , 这些算法称为 Tokenizer分词器 , 这些Token会被进一步处理, 比如转成小写等, 这些处理算法被称为 Token Filter词元处理器。

6、StringTokenizer 是一个Java的类,属于 javautil 包,用来分割字符串和枚举类型StringTokenizer 构造方法1 StringTokenizerString str 构造一个用来解析 str 的 StringTokenizer 对象使用默认的分隔符空格quotquot。

tokenizer.tokenize

1、情况是 我用 add_tokens方法 添加自己的新词后,BertTokenizerfrom_pretrainedmodel一直处于加载中原因 有说是词典太大,耗时hours才加载出来我也没有真的等到过暂时的解决办法参考于。

2、先说一下思路,首先获取一下,你想要截取的分割符在整个串中的位置 比如你说的这个分割符在整个abcefg中的位置可以采用indexof操作来获取他的位置有了这个位置之后,就可以使用substring函数来截取字符串了 从第一个。

3、想要解决这个问题,就需要一个Tokenizer将连续的语音特征映射至离散的标签受文本预训练方法BERT的启发,语音表示学习模型HuBERT 2利用MFCC特征或者Transformer中间层表示的kmeans模型作为Tokenizer,将语音转换为离散的标签。

4、alist小雅替换token如下1首先,我们使用tokenizer的encode方法将句子转换为一个token序列,其中add_special_tokens=False表示不添加特殊的起始和结束标记2然后,我们使用tokenizer的convert_tokens_to_ids方法将新的token。

5、frompytorch_pretrained_bertimportGPT2Tokenizer classPoemProcessorobjectdef__init__self,data_dir,tokenizerselfdata_dir=data_dir selftokenizer=tokenizer defprocessselfpoems=forfilenameinoslistdirself。

6、StringTokenizer类使用类,分析一个字符串并分解成可独立使用的单词StringTokenizer类有两个常用构造方法StringTokenizerString s为字符串s构造一个分析器使用默认的分隔符集合,即空格符。

7、此函数使用 tokenizers 包将原始数据框中的每一行文本分隔为标记默认标记化用于单词,但其他选项包括字符,ngram,句子,行,段落或正则表达式模式周围的分隔也就是修改下面这个参数既然数据是每行一个字的格式,我们。

还没有评论,来说两句吧...